2023年の北海道は、私にご褒美を与えてくれたのだと思います。丁度良い機会なので、ちょっと自分の人生を振り返ってみようと思いました。

北海道は 何回目になるのだろう

1977年の夏に1人でバイクに乗り、整備されていない国道4号線を北に向かいひたすら走り、野辺地港からフェリーの手続きを行い函館港に着いたのが最初の北海道でした。

その最初の道内入りで魅了された北の大地北海道ですが、未開発の自然が残り広々とした道路が果てしなく続いていて、普段の日常からはかけ離れている別世界でした。

当初は長い独身生活の間にバイクのツーリングで訪れ、結婚してからは家族と車に移りドライブ旅行で訪れました。子供が大きくなってからは、行動が徐々に変わって自然に触れる山歩きにシフトしました。

若い頃は 誘われての山歩き

幼少期は山に憧れることもなく、自発的に出掛けることなど皆無で、近くに妙義山があったので自転車で遊びながら妙義山を歩いた程度でした。山歩きの楽しさを知ったのは、入社した会社に山岳部があってバスで出掛けるハイキングを時々計画してくれ、人数確保のために私たち若手を動員するのが切っ掛けでした。

それらの動員は今でも記憶に残る楽しかった思い出になっています。でもその頃はバイクにしか思いが無くて、色々な場所に出掛けるのが忙しい時期でもあって、なかなか山歩きには向かいませんでした。

色々な山に誘われたのが今に影響

2月の厳冬期の八ヶ岳に誘われてツェルトで寝て、行動中は鼻の下に1センチ以上のつららが下がっていたのを見たり、年末年始の谷川岳でのキャンプに誘っていただき、そこで斜面をスキーで滑り降りる話を聞いたのがずっと記憶に残り、周囲にいる同期入社より10年遅れてスキーを習い始める切っ掛けになりました。それが今でも冬の体力維持にスキー場に通うような現在に至っています。

今ではさすがに引退してますが、春先の山スキーにも誘われて、尾瀬・守門・浅草岳・北八ヶ岳・谷川岳と色々な場所が記憶に残っています。ゲレンデスキーでも本州の白馬・八方尾根・志賀高原・天元台・山形蔵王も微かに記憶があり、北海道の札幌周辺や富良野で滑った懐かしい思い出もあります。

山に興味を持つが体力が無くて最悪

家族ができてバイクを手放してからは、さすがにバイクのツーリングはできませんので山歩きに気持ちが傾き始めました。でも通勤している頃は、自分で思っているようには歩けない非力な日々が続いていました。

2009年秋は、大雪山中腹の北側にある沼の平に興味を持ち、会社のリフレッシュ休暇という制度を利用して、旭岳ロープウェーで登って歩いたのですが、途中のハイマツ等の樹木が茂る沢と登山道が重なり大きな岩が続く個所での上下動で、足腰の負担が耐え切れなくなりました。当時は登山用ストックとかポールと呼ばれる杖も無くて、4本足で歩きたいと真剣に考えました。その当時の大雪山は、本当に手付かずの大自然の中にありました。

この年は、雪も早くて9月中旬過ぎには安足間岳分岐から比布岳、当麻岳周辺が凍結していました。

沼の平は愛山渓温泉から登る

2年後の2011年に憧れる沼の平に再び訪れることにしました。前回は旭岳ロープウェーで登り裾合平分岐を過ぎて当麻乗越を通り沼の平に至ったわけですが、距離が長くなるので愛山渓温泉から入るのが普通なのだと後で知りました。

体力が無くてビバークした永山岳にも再び訪れてみたい気にもなり、愛山渓温泉から沼の平、当麻乗越、当麻岳、安足間岳、永山岳と歩いて一回りするコースの疲労度も分からないので様子を見ながら歩いてみようと考えました。

意外にも愛山渓温泉から一回りすることは、容易にできる事でした。

歩いて自信がつくと何度でも

当麻乗越から安足間岳の尾根歩きは、対岸に見える主峰旭岳と間に挟まれた窪地の裾合平が眼下に見え、タイミングよく紅葉で色付くと、まるでこの世のものとは思えない錦の景観が広がります。2015年に歩いて私は完全にここの場所に魅了されてしまいました。

会社を退職してからは自然に体力が

特に体力を付けるためのトレーニングをしていませんが、会社を退職してからは意外に山歩きをしても歩き通せてしまうのが不思議です。山の頂に立ちたい要望もなく、日本百名山を制覇する夢もないので、同じ場所に何度でも通う山歩きをしていますが、それが功を奏して今回は山からのご褒美を頂いたように感じた次第です。

今年誘われた大雪山の縦走に感謝

近所の『群馬のじゆうじん』さんに、銀泉台から大雪高原温泉への縦走を誘われました。私は秋に2度同じコースを歩いていますが、花の咲く雪解けの季節にも興味があって車2台を利用しての縦走も1人ではできませんので良い機会だと思いました。

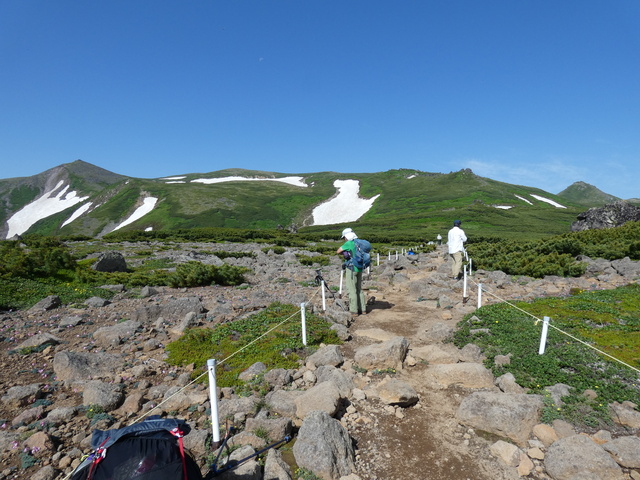

銀泉台からの登り始めになる第一花園です。

花の咲く時期と紅葉の秋とでは別の世界が広がる

赤岳の手前にある登りに駒草平が広がっています。

コマクサの大群落が広がる世界

国土地理院の地図にもある『駒草平』についてですが、花の無い秋に2度通っているこの場所、コマクサが自生するエリアだと特に気にも留めていませんでした。でも今回歩いて驚きの光景を目にしました。周囲には高山植物の女王と称されるコマクサが溢れるように咲き誇り、登山道にも踏みつぶしてしまう心配をするくらいに多数咲いていました。

周囲にも広い範囲で沢山の群落がありますが、踏み潰しそうな足元にも多数咲いています。

白雲岳のゼブラが広がる光景

銀泉台には止める車が多過ぎて、路肩駐車も延々と続く異常な世界が見られましたが、この人達が目指しているのは白雲岳から見えるゼブラなのだと知りました。

黒白のゼブラより、私は色が移り変わる秋の錦が好みです。でも皆が憧れるゼブラも美しいです。

花で知られる小泉岳は広範囲

花で知られる小泉岳は、赤岳から白雲岳に向かう登山道から緑岳に向かう登山道も含めて広範囲に色々な花が咲き誇っていました。NHKの朝ドラ「らんまん」で植物学者マキシモヴィッチの日本国内での助手(プラントハンター)の話が出てきましたが、実在の人物で 須川長之助 という人がいたようです。

そこから命名されたチョウノスケソウも咲いていました。白い花でちょっと見は同じ頃に白い花を付けるチングルマと混同されそうな花ですが、花弁数や葉や茎が大きく異なっているので見分けられるそうです。

チングルマは花弁5枚、チョウノスケソウは8枚でしょうか、中心が黄色く花弁が白で間違えそうです。

その周辺にも色々な花が咲いていました。

小泉岳から緑岳に向かう登山道はウルップソウ

礼文島のエゾカンゾウ

初めて訪れた礼文島ですが、島内全域にエゾカンゾウが咲いていました。エゾカンゾウは、サロベツ原生花園しか私の頭には無かったので、驚きと昔の霧ケ峰高原を黄色く染めていたニッコウキスゲの花を思い出しました。今でも残されて群生している黄色の花に本当に感動しました。

2023年は色々なことを再発見した年でした。